「AIを使ってみたいけど、データをクラウドに上げるのは不安…」「インターネットがない場所でも使いたい」。そんな悩みを解決するのが、自分のPC上でAIを動かす「ローカルAI」です。

この記事では、安定性と使いやすさで定評のあるLinux Mintで稼働するPCに、人気のローカルAI実行ツール「LM Studio」を導入し、手軽にAIと対話する方法を解説します。

なぜローカルAI? なぜLinux Mint?

ローカルAIには、クラウドベースのAIサービスにはない大きなメリットがあります。

- プライバシー保護: 入力した情報が外部に送信されないため、機密情報や個人情報を安全に扱えます。

- オフライン利用: インターネット接続がなくてもAIを利用できます。

- コスト管理: 一度環境を構築すれば、API利用料のような継続的な費用はかかりません。

そして、Linux Mintは、その安定した動作と直感的なデスクトップ環境から、ローカルAIを動かすためのプラットフォームとして非常に適しています。特に、Windowsからの移行者にも優しく、スムーズに導入を進められるでしょう。

準備するもの

- 今回はLinuxMintで稼働するパソコンで行っていきます。

- 十分なRAM: 最低でも8GBは必要ですが、16GB以上、32GBあればかなり快適に利用できます。

- CPU:Intel Core i5/i7 8000番台(=第8世代)以降のCPU、同等のRyzen5/7

- 可能であれば NVIDIA製GPU: CPUだけでも動作しますが、NVIDIAのグラフィックボードを搭載していると、AIの応答速度が劇的に向上します。

GUIで直感的!LM Studioのセットアップ

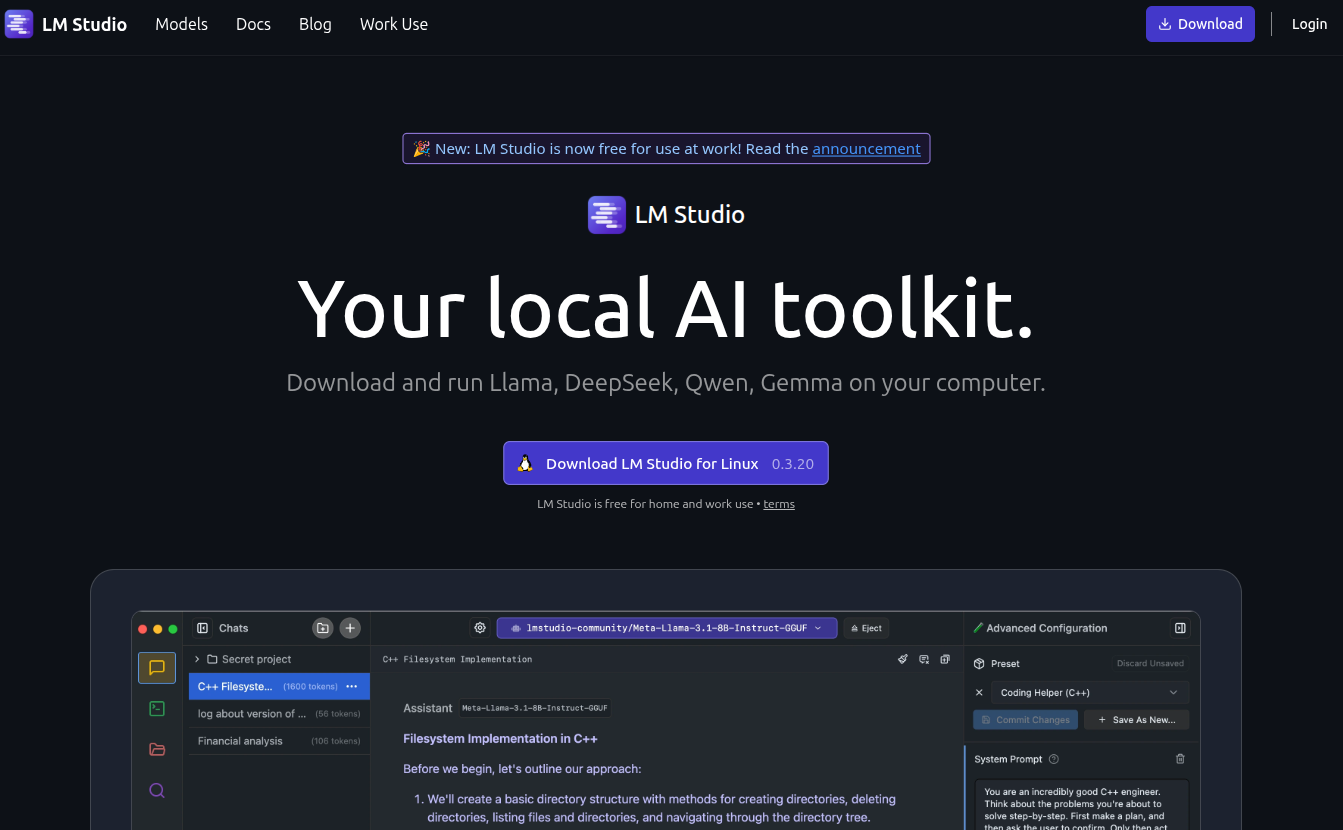

LM Studioとは?

LM Studioは、ローカルでLLMを実行するためのオールインワン・デスクトップアプリケーションです。

本来であれば複雑なコマンドライン操作が必要なモデルのダウンロードや設定を、直感的なGUI(グラフィカル・ユーザー・インターフェース)で完結できるのが最大の特徴です。

- Hugging Face(AIモデルの巨大なリポジトリ)からモデルを簡単に検索・ダウンロード

- ダウンロードしたモデルですぐにチャットを開始

- ローカルAPIサーバー機能で、他のアプリケーションとの連携も可能

まさに、ローカルAI入門に最適なツールと言えるでしょう。

STEP1: LM Studioのインストール

それでは、早速LinuxMintにLM Studioをインストールしていきましょう。

1. AppImageファイルのダウンロード

- まず、ウェブブラウザでLM Studioの公式サイトにアクセスします。https://lmstudio.ai/

- トップページにある「Download LM Studio for Linux」というボタンをクリックして、AppImageファイルをダウンロードします。通常は

~/Downloads(ダウンロード)フォルダに保存されます。

LM Studioは、Linux向けにAppImageという形式で配布されています。これは、インストール不要で単一のファイルとして実行できる便利な形式です。

2. 実行権限の付与

ダウンロードしたAppImageファイルは、そのままだと実行できません。ファイルに「実行する権限」を与える必要があります。

- ファイルマネージャーを開き、ダウンロードしたファイル(例:

LM-Studio-x.xx.x-x86_64.AppImage)がある場所へ移動します。 - ファイルを右クリックし、「プロパティ」を選択します。

- 開いたウィンドウの「パーミッション」タブに移動します。

- 「実行:」という項目の「ファイルを実行可能にする」または「プログラムとしての実行を許可する」といった内容のチェックボックスをオンにします。

- プロパティウィンドウを閉じます。

ターミナル(端末)を使う場合は、以下のコマンドでも同様の操作が可能です。

# ダウンロードフォルダに移動

cd ~/Downloads

# 実行権限を付与(ファイル名は適宜変更してください)

chmod +x LM-Studio-*.AppImage

3. LM Studioの起動

これで準備は完了です。ファイルマネージャーでAppImageファイルをダブルクリックすれば、LM Studioが起動します。

STEP2: AIモデルのダウンロード

LM Studioが起動したら、次にお目当てのAIモデルを探してダウンロードします。

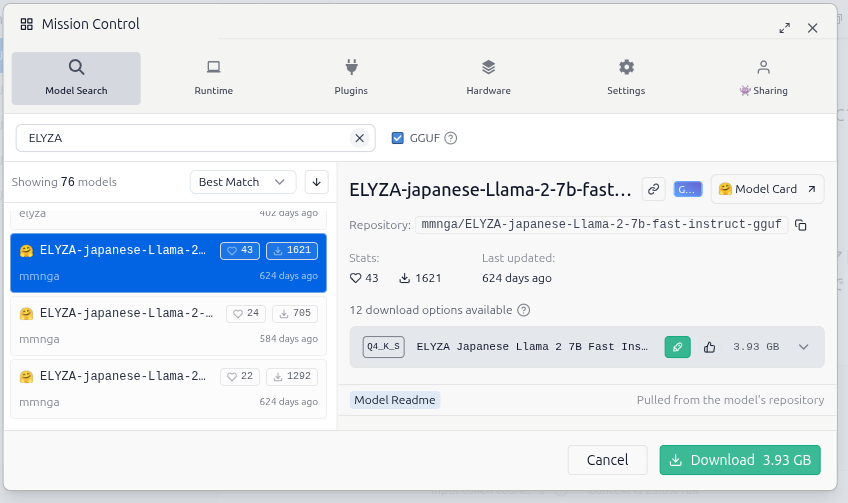

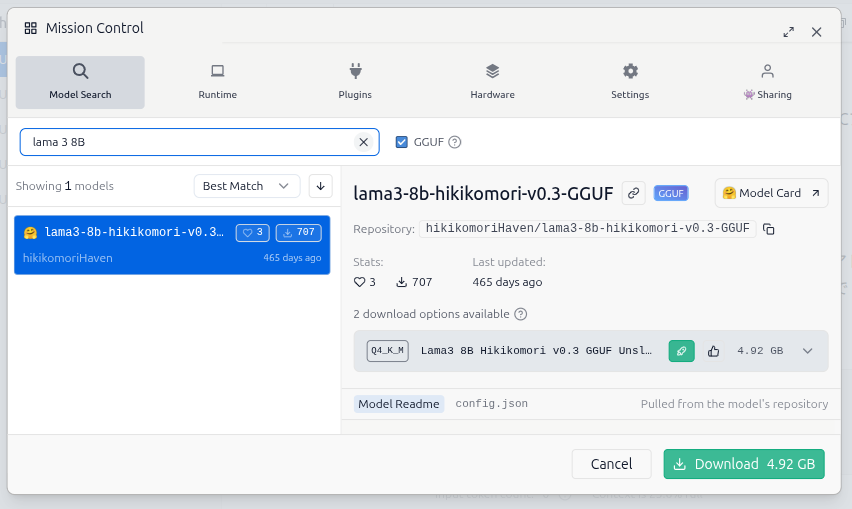

モデルの検索: LM Studioのホーム画面(虫眼鏡アイコン 🔍)の上部にある検索バーに、興味のあるモデル名を入力します。

今回は、日本語性能が高く、比較的に軽量で人気の高い「ELYZA-japanese-Llama-2-7b-fast-instruct」を探してみましょう。

モデルの選択とダウンロード: 検索結果に表示されたモデルの中から、目的のものをクリックします。画面右側に、そのモデルの様々なバージョン(ファイル)が表示されます。

ポイント: ファイル名に GGUF と書かれているものが、LM Studioで利用できる形式です。

量子化 (Quantization): ファイル名の Q4_K_M や Q5_K_S といった部分は「量子化」のレベルを表します。ざっくり言うと、数字が大きいほど高性能ですが、ファイルサイズが大きく、より多くのPCスペック(特にRAM)を要求します。まずは Q4_K_M あたりから試すのがおすすめです。

ダウンロードしたいファイルの右側にある「Download」ボタンをクリックします。画面下部にダウンロードの進捗状況が表示されます。完了するまでしばらく待ちましょう。

モデルの切り替え

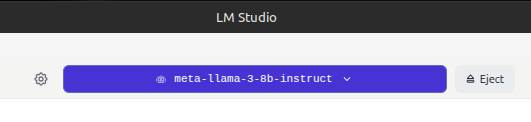

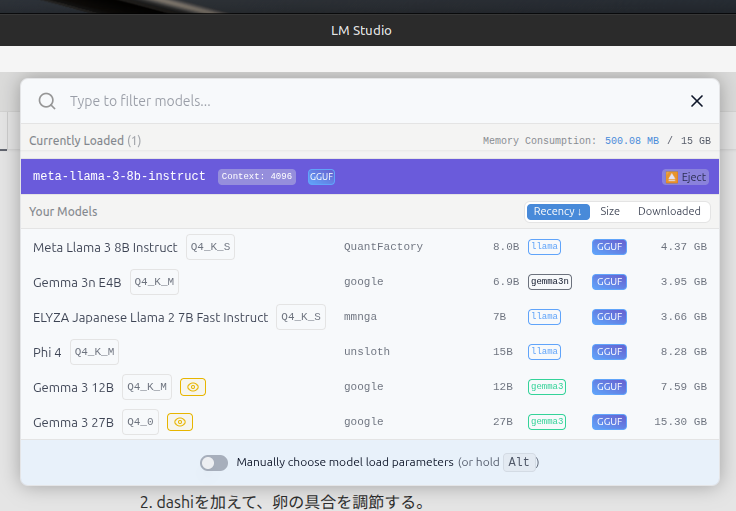

数あるモデルの中から複数のモデルをダウンロードしておいて切り替えて使うことができます。

画面上部の青紫のバーに現在選択されているモデル名が表示されていますが、この部分をクリック。

ダウンロード済みのモデルが一覧で表示されるので、利用したいモデルをクリックして選択してロードさせます。

STEP3: AIとチャットしてみよう!

モデルのダウンロードが完了したら、いよいよAIとの対話です。

- 画面左のメニューから、吹き出しのアイコン

💬(AI Chat)をクリックします。 - 画面上部中央の「Select a model to load」と書かれたボタンをクリックし、先ほどダウンロードしたモデルを選択します。モデルがPCのメモリに読み込まれるまで少し時間がかかります。

- モデルの読み込みが完了すると、中央にチャット画面が表示されます。下部の入力欄に「こんにちは!」や「LinuxMintの便利な使い方を教えて」など、自由にメッセージを入力してEnterキーを押してみてください。

AIがあなたのPCの中だけで考えて、応答を返してくれます!

はじめてのLM StudioでローカルAIにオススメのAIモデル

搭載メモリーが16GBでGPU(グラフィックスボード)がないLinuxMint PCで、はじめてローカルAIを試してみるときにオススメのモデルをいくつかご紹介いたします。

この環境で重要なのは、「モデルサイズ」と「量子化」のバランスです。

16GBのメモリーを有効に使うため、7B= 70億パラメータ)クラスのモデルを4bit〜5bitに量子化(軽量化)したGGUF形式のファイル(サイズが4GB〜10GB程度のもの)を選ぶのが最適だと思います。

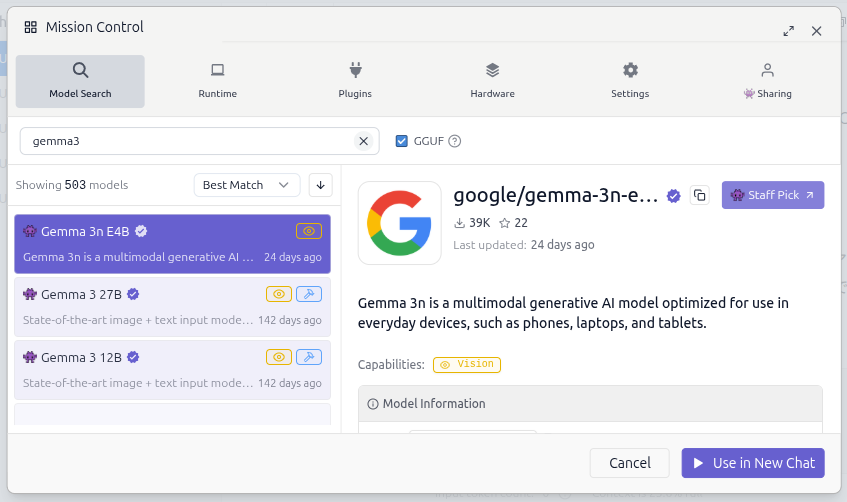

1,Gemma 3 E4B

テキストだけでなく画像や動画などの視覚情報も処理できるマルチモーダルに対応。多言語対応が140以上の言語に拡充され、より自然な翻訳や多言語処理が可能となっています。

パソコンはもちろん、スマートフォンでも稼働可能な「オンデバイスAI」の大きな進歩を象徴するものとなっています。

2,Llama 3 8B Instruct

Meta社が開発した最新モデルで、性能、速度、汎用性のすべてにおいて非常に高いレベルにあります。一般的なチャットから、文章の要約、アイデア出し、プログラミングのコード生成まで、あらゆるタスクを高い精度でこなします。

- 特徴: 非常に高い対話能力と指示応答性。思考の「賢さ」を感じられます。

- おすすめ用途: あらゆる用途に。かなり前のモデルなのでアップデートに注目。

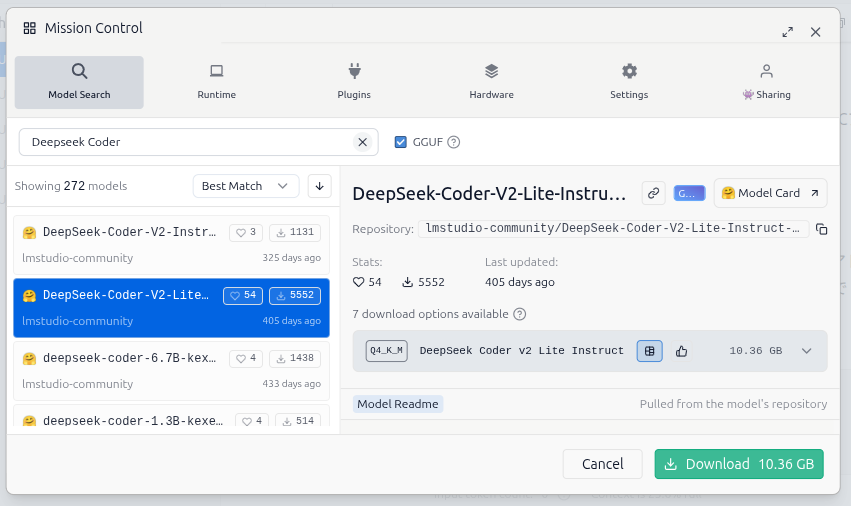

3,Deepseek Coder V2 Lite Instruct

プログラミングに特化した、コーディング支援モデル。

コーディングが主な目的なら、このモデルが第一候補になると思います。多くのプログラミング言語に対応し、コードの生成、デバッグ、アルゴリズムの相談などで専門的な能力を発揮します。汎用モデルよりも的確なコードを提案してくれることが多く、開発者にとって強力な相棒になることでしょう。

- 特徴: コーディングに特化。238のプログラミング言語を学習済み。

- おすすめ用途: プログラミング全般、コードレビュー、技術的な質問。

LM Studioの終了

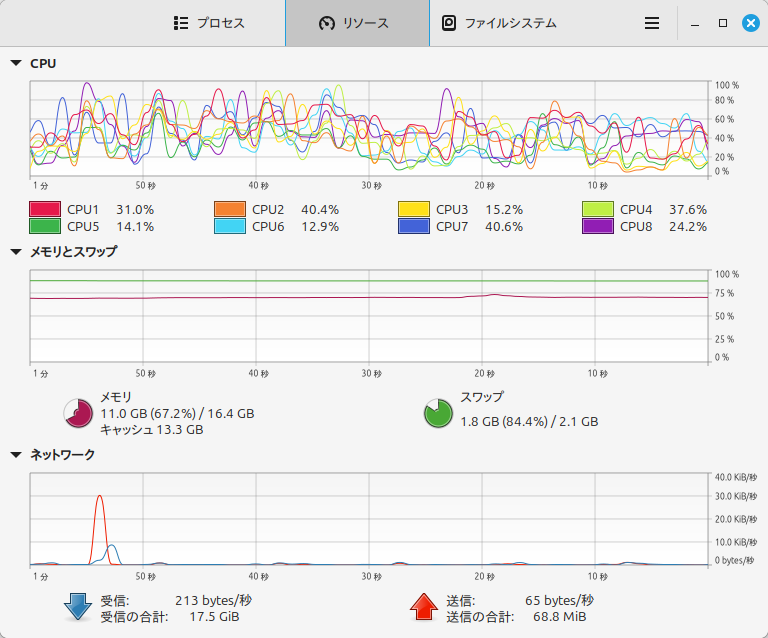

LM Studioは使用中、かなりメモリーを消費します。上記3つのモデルで約8〜10GBのメモリーを使用することになります。

メモリーの使用状況は「システムモニター」アプリで確認することができます。

Chromeでたくさんタブを開いた状態でLM Studioを利用するとメモリーが逼迫してしまうことがあり、動作が遅くなってしまうことがあるので、システムモニターで状況をチェックしておくといいでしょう。

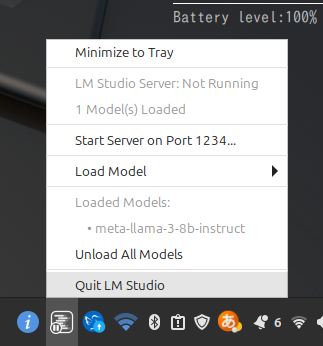

LM Studioを閉じてもメモリーが解放されません。一度起動するとシステムに常駐します。

完全に終了するには、パネル内のアイコン(下記画像の左から2番め)を右クリックして、「Quit LM Studio」で完全に終了させることができます。

コメント